人工智能与人类的价值观保持一致

编程小助手

2024-04-23 23:15

让AI与人类的价值观保持一致,怎么就这么难?中国人工智能发展迅猛,中国政府也高度重视人工智能领域的发展。预计到2020年,中国人工智能产业规模将超过1500亿元,带动相关产业规模超过1万亿元。2017年全球新兴人工智能项目中,中国占据51%,数量上已经超越美国。但全球人工智能人才储备,中国却只有5%左右,人工智能的人才缺口超过500万。

几十年以来,我们一直在努力按自己的形象开发出人工智能。在此期间,我们也始终致力于创造一种既像人类一样睿智、又像人类一样愚蠢的机器。

但经过六十年的研发,让AI系统在目标、意图与价值观层面与人类保持统一,仍是个遥不可及的目标。AI几乎已经在各个主要领域达到与人类智能相近、甚至更高的水平,但又总是在最核心的范畴内有所欠缺。正是这种欠缺,导致AI技术无法成为我们所期望的、真正拥有更改及行事逻辑的智能主体。

程序员兼研究员Brian Christian在最新著作《机器学习与人类价值观之间的一致性问题》(The Alignment Problem: Machine Learning and Human Value)当中,讨论了我们该怎样确保AI模型能够捕捉到“我们的规范与价值观,理解我们的意思或意图,并据此做出优先级判断”这一现实挑战。近年来,随着机器学习应用范围的逐步推广,在实际领域中做出错误决策很可能带来灾难性的后果。正是这样的背景,让Christian提出的问题变得愈发紧迫。

根据Christian所述,“随着机器学习系统的日益普及与功能的逐步增强,我们开始变得像「新手巫师」——我们掌握着一种具有自主性的力量,我们似乎可以用指令引导这种力量,但如果指示不够准确或不够完整,就有可能引发某些可怕且超出意料的后果。”

在书中,Christian全面描述了人工智能的现状以及整个发展历程,同时探讨了现有AI创建方法的种种缺陷。

下面来看书中的几大要点。

机器学习:将输入映射至输出

在AI研究的前几十年中,符号系统在解决以往涉及逻辑推理的复杂问题时,取得了举世瞩目的成就。然而,这类系统反而很难解决人类儿童就能处理的小问题——例如检测物体、识别人脸、理解声音与语音。此外,这类系统的可扩展性也比较差,往往需要大量人工介入以建立明确的规则与知识定义。

最近,全世界对机器学习与深度学习的关注开始快速增长,同时也推动着计算机视觉、语音识别与自然语言处理等领域(传统符号AI无法处理的领域)的迅猛发展。机器学习算法可以跟随数据量与计算资源同步扩展,借此带来了人工智能的黄金十年。

但问题在于,机器学习算法的效果虽然相当突出,但本质却仍然简陋——将观察结果通过复杂的数学函数与结果映射起来。因此,机器学习的质量将直接由数据质量决定,而且会在实际应用并接触到与训练数据不符的真实素材时,产生严重的性能下降。

在书中,Christian列举了一系列实例,阐述机器学习算法遭遇的各种尴尬、甚至具有危害性的破坏。以Google Photos分类算法为例,该算法会将皮肤黝黑的人标记为大猩猩。问题不在算法本身,而在于所使用的训练数据。如果谷歌能够在数据集中纳入更多皮肤黝黑的素材,完全可以避免这个问题。

Christian写道,“当然,从理论上讲,这类系统可以从一组示例中学到任何知识。但这也意味着AI系统的理解方式完全受示例左右。”

更糟糕的是,机器学习模型无法分辨对错,也无法做出道德决策。机器学习模型的训练数据中存在的任何问题,通常都会以极细微、甚至根本无法察觉的方式反映在模型行为当中。例如,Amazon于2018年关闭了用于做出雇用决策的机器学习工具,因为其决策结果明显歧视女性。很明显,AI的创造者并不希望根据性别来选择候选人,但由于模型训练使用的数据来自Amazon公司的过往记录,因此反映出了其用人方面的某些倾向。

这还只是机器学习模型偏见问题中的冰山一角。正是由于存在这些问题,由于机器学习模型会盲目根据我们以往的行为总结经验,才让我们无法充分信任这类工具。

Christian写道,“对真实世界建模相对简单,但模型在付诸使用后总会出现种种变化,甚至反过来改变这个世界。目前大部分机器学习模型在设计当中存在一种广泛假设,即模型本身不会改变其建模所依据的现实。但这种假设几乎完全站不住脚。实际上,草率部署这类模型很可能会产生反馈循环,导致我们越来越难以将其扳回正轨。”

对于数据收集、模式查找以及将模式转化为行动等层面,人类智能应该发挥更大的作用。机器学习的现实挑战已经证明,我们对于数据乃至机器学习的很多假设性认识完全是错的。

Christian警告称,“我们需要作出批判性思考……除了重视训练数据的来源,还应重视系统中作为基本事实的标签来源。人们认为的基本事实,往往并不是基本事实。”

强化学习:奖励最大化

强化学习同样帮助研究人员实现了非凡的成就,使得AI能够在复杂的电子游戏中击败人类冠军。

过去十年以来,作为AI技术的另一大分支,强化学习同样获得了广泛关注。强化学习要求为模型提供问题空间加奖励函数规则,之后就由模型自主探索整个空间,找出能够实现奖励最大化的方法。

Christian写道,“强化学习……帮助我们一步步探索着智能的普遍、甚至是最本质的定义。如果说John McCarthy提出的「智能是实现真实目标的能力中的计算部分」的说法真实可靠,那么强化学习相当于提供了一套惊人的通用型工具箱。它的核心机理就是在一次又一次试错当中,摸索出新时代下一切人工智能方案的共通基础。”

强化学习确实在雅达利游戏、围棋、《星际争霸2》以及DOTA 2等游戏中表现出色,并在机器人技术领域得到广泛应用。但成功的背后人们也开始意识到,单纯追求外部奖励并不能完全体现智能的运作方式。

一方面,强化学习模型需要漫长的训练周期才能得出简单的判断能力。因此,这方面研究成为极少数掌握无穷资源的科技巨头的专利。另外,强化学习系统的适用性也非常有限——能够在《星际争霸2》中击败人类世界冠军的系统,却无法在其他类似的游戏中触类旁通。强化学习代理也更倾向于通过无止境的循环,以牺牲长期目标的方式追求最简单的奖励最大化路径。以赛车游戏AI为例,它经常会陷入不断收集奖励物品的死循环,却总是赢不下整场比赛。

Christian认为,“消除这种与外部奖励的硬性联系,可能才是构建通用型AI的诀窍所在。因为与雅达利游戏不同,真实生活并不会为我们的每种行为预先设定明确的实时反馈。当然,我们有父母、有老师,他们可以及时纠正我们的拼写、发音和行为模式。但是,这些并不是人生的全部,我们的生活不可能由权威所全面掌控。我们需要根据自己的观点与立场做出判断,这也正是人类族群得以存续发展的根本前提。”

Christian还建议,不妨根据强化学习的原理反其道而行之,“结合预期行为考虑如何构建环境奖励,引导模型一步步掌握行为模式。这就像是面对美食评论家做出一份份食物,思考如何才能获得对方的肯定。”

AI有必要模仿人类吗?

在书中,Christian还讨论了开发AI代理的意义——让这些代理模仿人类行为,真的有意义吗?自动驾驶汽车就是典型实例,代理会通过观察人类司机学习如何驾驶车辆。

模仿确实可以创造奇迹,特别善于处理规则及标签不够明确的问题。但是,模仿也会继承人类智能中的欠缺。人类在年轻时往往通过模仿与死记硬背学习大量知识,但模仿只是我们发展出智能行为的多种机制之一。在观察他人的行为时,我们会根据自己的限制、意图、目标、需求以及价值观调整出适合自己的处理方式。

Christian写道,“如果模仿对象比我们更快、更强壮、身材更高大,那我们就没办法完美模仿他们。这时候一味坚持模仿,只会影响我们解决问题的能力。”

诚然,AI系统确实通过观察并预测我们的行为,尝试以模仿的方式提供帮助。但很明显,AI系统并不像人类这样受到种种约束与限制,因此会导致其误解我们的意图,甚至放大我们的某些不良习惯,最终将负面影响扩散到我们生活中的方方面面。

Christian写道,“我们的数字管家正密切关注我们的私人生活与公共生活,审视着我们好的一面与坏的一面,但却并不清楚这些因素到底有何区别、有何联系。AI系统好似生活在一处诡异而复杂的山谷:能够从我们的行为中推理出复杂的人类欲望模型,但却无法理解这些欲望从何而来。它们努力思考接下来该做什么,但不了解我们想要什么、又是怎样成长为我们自己。”

未来在哪里?

机器学习的进步表明,我们在创造思想机器方面已经取得了一定成就。但是,机器学习带来的挑战与影响,也再次提醒我们应该正视理解人类智能这一前提性难题。

AI科学家与研究人员正探索多种不同方法,希望克服这些障碍,打造出让人类只受益、不受害的AI系统。而在达成这项目标之前,我们需要谨慎行事,不可贸然为这类系统赋予过多权限。

Christian最后警告称,“着眼于当下,最危险的行为就是在机器学习领域找到一种看似合理的模型、急于宣告研究成功——这可能会给整个社会带来灾难性的后果。”

以培养掌握人工智能理论与工程技术的专门人才为目标,学习机器学习的理论和方法、深度学习框架、工具与实践平台、自然语言处理技术、语音处理与识别技术、视觉智能处理技术、国际人工智能专业领域最前沿的理论方法,培养人工智能专业技能和素养,构建解决科研和实际工程问题的专业思维、专业方法和专业嗅觉。

免责声明:

① 本站未注明“稿件来源”的信息均来自网络整理。其文字、图片和音视频稿件的所属权归原作者所有。本站收集整理出于非商业性的教育和科研之目的,并不意味着本站赞同其观点或证实其内容的真实性。仅作为临时的测试数据,供内部测试之用。本站并未授权任何人以任何方式主动获取本站任何信息。

② 本站未注明“稿件来源”的临时测试数据将在测试完成后最终做删除处理。有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

人工智能与人类的价值观保持一致

下载Word文档到电脑,方便收藏和打印~

相关文章

- Java 中哪些字符需要进行转义?(java需要转义的字符有哪些)

- 如何在 Java 中调用类方法?(java怎么调用类方法)

- 如何在同一项目中巧妙地混合使用 Node.js 与 Java?(如何在同一项目中混合使用Node.js与Java)

- 如何在 Java 中设置时间间隔?(java怎么设置时间间隔)

- 如何解决 Java 反向代理错误?(java反向代理错误怎么解决)

- Java 中的 trimend 在大数据处理中是如何应用的?(Java trimend在大数据处理中的应用)

- Java 中字符串数组初始化的方式有哪些?(java字符串数组初始化的方法是什么)

- 在 Java 中,enum 能否继承其他类?(java中enum可以继承其他类吗 )

- 在 Java 中进行字符串截取时,有哪些需要特别注意的事项?(java中字符串截取时要注意哪些事项)

- Apache APISIX Java 的社区支持情况如何?(apisix Java的社区支持情况)

猜你喜欢

让AI与人类的价值观保持一致,怎么就这么难?

OpenAI组建新团队:收集公众意见以确保AI大模型"与人类价值观保持一致"

了解一下人工智能的关键技术与观点

NLP如何实现人工智能在医疗保健领域的价值

人工智能与大数据:发现商业价值的数据洞察

人工智能、自动化与新兴技术趋势,正在颠覆价值4.6万亿的货币市场

编程热搜

人工智能你要知道的那些事

编程学习网:早在1g时代我们只能接打电话。2g时代可以打电话发短信,玩早期的qq,但网络十分不稳定。3g时代带给我们很大的改变就是宽带上网,视频通话,看视频,听歌玩游戏。那时的人们认为4g无用,认为不会有什么改变,但当4g出来时我们才发现这是一次质的飞跃。![人工智能你要知道的那些事]()

人工智能无人机管制到底有多难?

编程学习网:近日,一段“重庆网红列车遭无人机撞击逼停”的视频,在网络热传。![人工智能无人机管制到底有多难?]()

人工智能与人类

欢迎各位阅读本篇,人工智能是计算机科学的一个分支,它企图了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器,该领域的研究包括机器人、语言识别、图像识别、自然语言处理和专家系统等。本篇文章讲述了人工智能与人类,编程学习网教育平台提醒各位:本篇文章纯干货~因此大家一定要认真阅读本篇文章哦!![人工智能与人类]()

两小时 Elasticsearch 性能优化,直接把慢查询干团灭了……

公共集群的机器负载分布不均衡的问题,业务的查询和流量不可控等各种各样的问题,要节省机器资源就一定会面对这种各种各样的问题,除非土豪式做法,每个业务都拥有自己的机器资源,这里面有很多很多颇具技术挑战的事情。![两小时 Elasticsearch 性能优化,直接把慢查询干团灭了……]()

关于OpenStack的架构详细讲解

欢迎各位阅读本篇文章,OpenStack是一个开源的云计算管理平台项目,由几个主要的组件组合起来完成具体工作。本篇文章讲述了关于OpenStack的架构详细讲解,编程学习网教育平台提醒各位:本篇文章纯干货~因此大家一定要认真阅读本篇文章哦!![关于OpenStack的架构详细讲解]()

AI &神经网络

欢迎各位阅读本篇,本篇文章讲述了AI &神经网络,人工智能(Artificial Intelligence),英文缩写为AI。它是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。神经网络内容丰富,反映了当前国内外该领域的最新研究成果和动向,编程学习网教育平台提醒各位:本篇文章纯干货~因此大家一定要认真阅读本篇文章哦!![AI &神经网络]()

人工智能对于网络安全的优缺点

编程学习网:如今,产生的数据比以往任何时候都要多。由于数据分析工具的发展,各行各业的组织都更加重视大数据的收集和存储。![人工智能对于网络安全的优缺点]()

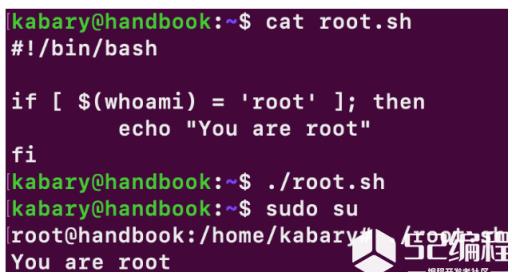

Bash 初学者系列 7:bash 中的条件语句(if else)

今天我们介绍一下如何在 bash 中使用条件语句。![Bash 初学者系列 7:bash 中的条件语句(if else)]()

人工智能机器学习的重要趋势是什么?

编程学习网:在竞争日益激烈的技术市场中,从高科技初创公司到全球跨国公司都将人工智能视为关键竞争优势。但是,人工智能行业发展如此之快,以至于很难跟踪最新的研究突破和成就,甚至很难应用科学成果来实现业务成果。![人工智能机器学习的重要趋势是什么?]()

人工智能为什么会觉得Matplotlib用起来困难?

编程学习网:Matplotlib是一个流行的Python库,可以很容易地用于创建数据可视化。![人工智能为什么会觉得Matplotlib用起来困难?]()

编程资源站

- 资料下载

- 历年试题