pytorch实现线性回归的方法

短信预约 -IT技能 免费直播动态提醒

这篇文章主要介绍“pytorch实现线性回归的方法”,在日常操作中,相信很多人在pytorch实现线性回归的方法问题上存在疑惑,小编查阅了各式资料,整理出简单好用的操作方法,希望对大家解答”pytorch实现线性回归的方法”的疑惑有所帮助!接下来,请跟着小编一起来学习吧!

线性回归都是包括以下几个步骤:定义模型、选择损失函数、选择优化函数、 训练数据、测试

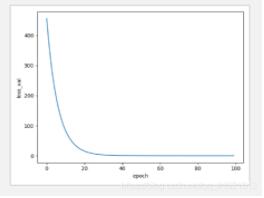

import torchimport matplotlib.pyplot as plt# 构建数据集x_data= torch.Tensor([[1.0],[2.0],[3.0],[4.0],[5.0],[6.0]])y_data= torch.Tensor([[2.0],[4.0],[6.0],[8.0],[10.0],[12.0]])#定义模型class LinearModel(torch.nn.Module): def __init__(self): super(LinearModel, self).__init__() self.linear= torch.nn.Linear(1,1) #表示输入输出都只有一层,相当于前向传播中的函数模型,因为我们一般都不知道函数是什么形式的 def forward(self, x): y_pred= self.linear(x) return y_predmodel= LinearModel()# 使用均方误差作为损失函数criterion= torch.nn.MSELoss(size_average= False)#使用梯度下降作为优化SGD# 从下面几种优化器的生成结果图像可以看出,SGD和ASGD效果最好,因为他们的图像收敛速度最快optimizer= torch.optim.SGD(model.parameters(),lr=0.01)# ASGD# optimizer= torch.optim.ASGD(model.parameters(),lr=0.01)# optimizer= torch.optim.Adagrad(model.parameters(), lr= 0.01)# optimizer= torch.optim.RMSprop(model.parameters(), lr= 0.01)# optimizer= torch.optim.Adamax(model.parameters(),lr= 0.01)# 训练epoch_list=[]loss_list=[]for epoch in range(100): y_pred= model(x_data) loss= criterion(y_pred, y_data) epoch_list.append(epoch) loss_list.append(loss.item()) print(epoch, loss.item()) optimizer.zero_grad() #梯度归零 loss.backward() #反向传播 optimizer.step() #更新参数 print("w= ", model.linear.weight.item())print("b= ",model.linear.bias.item()) x_test= torch.Tensor([[7.0]])y_test= model(x_test)print("y_pred= ",y_test.data) plt.plot(epoch_list, loss_list)plt.xlabel("epoch")plt.ylabel("loss_val")plt.show()使用SGD优化器图像:

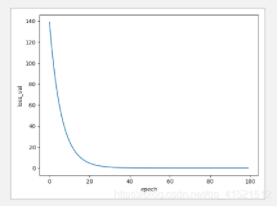

使用ASGD优化器图像:

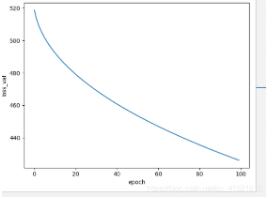

使用Adagrad优化器图像:

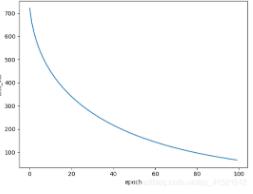

使用Adamax优化器图像:

到此,关于“pytorch实现线性回归的方法”的学习就结束了,希望能够解决大家的疑惑。理论与实践的搭配能更好的帮助大家学习,快去试试吧!若想继续学习更多相关知识,请继续关注编程网网站,小编会继续努力为大家带来更多实用的文章!

免责声明:

① 本站未注明“稿件来源”的信息均来自网络整理。其文字、图片和音视频稿件的所属权归原作者所有。本站收集整理出于非商业性的教育和科研之目的,并不意味着本站赞同其观点或证实其内容的真实性。仅作为临时的测试数据,供内部测试之用。本站并未授权任何人以任何方式主动获取本站任何信息。

② 本站未注明“稿件来源”的临时测试数据将在测试完成后最终做删除处理。有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341