【距离注意残差网络:超分】

DARN: Distance Attention Residual Network for Lightweight Remote-Sensing Image Superresolution

(DARN:用于轻量级遥感图像超分辨率的距离注意残差网络)

单图像超分辨率技术在遥感领域的应用具有重要意义。尽管基于卷积神经网络(CNN)的SISR方法取得了很好的效果,但由于模型庞大,速度较慢,难以在真实的遥感任务中部署。在这篇文章中,我们提出了一个紧凑而有效的距离注意力残差网络(DARN),以实现模型准确性和复杂性之间的更好折衷。距离注意残差连接块(DARCB),DARN的核心组件,使用多级特征聚合来学习更准确的特征表示。DARCB的主分支采用浅残差块(SRB)来灵活地学习残差信息,以确保模型的鲁棒性。我们还提出了一个距离注意块(DAB) 作为主分支和DARCB分支之间的桥梁; DAB可以有效地减轻深度CNN提取过程中细节特征的损失。在两个遥感和五个超分辨率基准数据集上的实验结果表明,DARN在性能和模型复杂度方面比现有方法实现了更好的折衷。此外,DARN实现了最佳的解决方案相比,国家的最先进的轻量级遥感SISR方法的参数量,计算量和推理速度。

INTRODUCTION

超分辨率(SR)重建是指在一对高分辨率和低分辨率图像之间构建非线性映射关系。单幅图像超分辨率(SISR)作为最具代表性的低层视觉任务,已经得到了广泛的研究。SISR算法可以获得高清晰度图像,这使得它在军事,工业,航空航天和遥感等各个领域做出了巨大贡献。然而,在遥感领域的数据采集受到长距离,宽视角和光学硬件设备的影响。即使有先进的采集设备,也很难获得满足使命需要的高清晰度图像。因此,研究能够恢复遥感图像高频信息的SISR算法具有重要意义。

自从第一个开创性的SISR方法class="lazy" data-srcNN被提出以来,低分辨率图像到高分辨率图像的端到端映射已经被纳入SR重建方法中,但新的解决方案不可避免地留下了一些必须解决的缺陷。例如,卷积核和非线性映射的不合理设计导致网络推理非常缓慢。Fclass="lazy" data-srcNN基于class="lazy" data-srcNN框架导出了一些依赖于不同算法的优化方法。ESPCN通过用子像素卷积函数代替传统的插值上采样来提高重建精度。更深的卷积神经网络(CNN)架构被证明可以提高模型性能。[11]提出的密集残差块可以缓解长距离残差造成的局部信息丢失问题。

在前人对CNN探索的基础上,SISR理论逐渐成熟。然而,这些总是试图通过增加模型容量来提高模型精度的方法在实际任务中难以显示应用价值。特别是遥感图像的大分辨率特性往往导致常用SISR算法的推理速度极慢。因此,如何设计一个轻量级、高效、准确的SISR模型已成为SR领域一个难以克服的问题。

从试图减少模型参数的角度来看,DRCN和DRRN采用了递归的方式来增加模型参数共享,但递归损失需要更深的CNN进行信息补偿,这使得它被迫降低模型的推理速度。CAUN-M试图通过参数修剪来去除或减少特征冗余,加快模型推理,但PSNR遭受了很大的准确性损失。显然,为了在模型的精度、速度和参数量之间取得一个有效的折衷,必须在有限的参数量范围内加强特征的表达能力。因此,由信息蒸馏网络(IDN)提出的信息蒸馏方法可以通过分裂特征通道以减少特征冗余来实现适度的折衷。然而,简单的通道分裂方法由于丢失了部分深层特征信息,限制了模型提取有效特征的性能。LEclass="lazy" data-srcNN采用的异构结构可以通过灵活结合低频特征和高频特征来提高模型重构能力。MADNet通过类似于inception的多边残差模块加速了模型的推断。然而,这种多分支推理解决方案也遭受模型参数的大比例的缺点。在SR领域,FeNet受到IDN信道分裂的想法的启发,构建了一个轻量级的LLB模块。为了达到增强信道特征表达的目的,LLB模块采用信道注意机制构建上下分支的信息通信,同时信道分裂降低了模型参数。然而,在信息蒸馏的过程中出现了另一个问题。也就是说,在分裂通道时,蒸馏过程中产生的侧分支总是留下不能有效提取深度特征的缺陷。

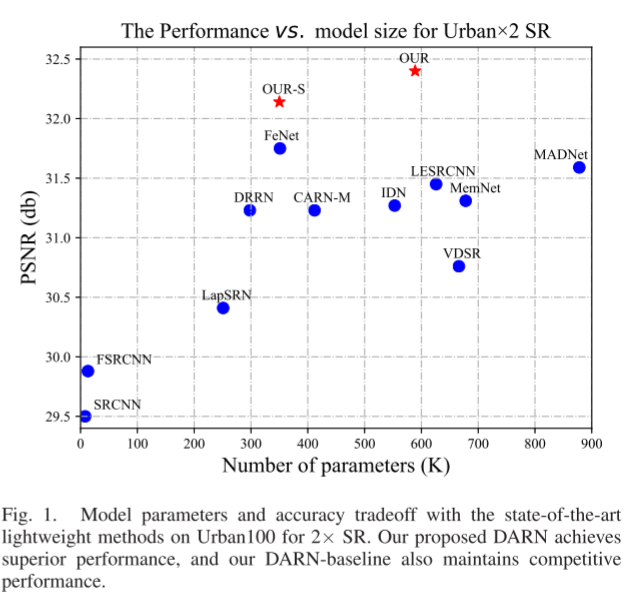

本文构造了一种新颖的轻量级SR网络,即距离注意残差网络(DARN)来解决上述问题。DARN通过加强特征通道信息的表示和引入有效的注意力模块来提高网络的重构能力。我们构造的距离注意残差连接块(DARCB)是DARN的核心组件。DARCB通过特征细化卷积将输入特征显式地分成两个分支。其中,保留分支细化后的特征,并通过CNN模块进一步细化提取主分支。DARCB使用的CNN是基于卷积层、跨越连接和结束激活单元的浅残差块(SRB)。增强特征表示的最有效的解决方案是减少通道特征冗余并减轻深CNN引起的浅层特征丢失。这就是我们构建距离注意块(DAB)的具体原因。距离注意是指浅层特征可以通过注意的手段远程控制主分支中每个SRB的特征提取。DAB将分支的浅层特征作为先验信息,可以有效缓解主干深度CNN特征提取中浅层信息丢失的现象,从而增强模块的特征表达。最后,采用多级融合机制对每一级的细化特征进行融合,以减少主分支冗余特征对模块输出的影响。适当地引入注意模块有效地提高了SR网络的性能。因此,我们引入了一个增强的空间注意力(ESA)模块,以加强在本文中构建的模型的能力。如图1,所提出的DARN方法实现了最先进的重建性能时,与现有的轻量级SR网络相比。特别是我们的型号DARN-S在足够轻量化的前提下,仍然具有相当大的竞争优势。这得益于本文中提出的DARCB模块强大的特征表达能力。

本文的贡献如下:

1)设计DARCB组件以使用多级特征聚合来增强特征表示,与简单的CNN级联模块相比,实现了superior progress。

2)构建的DAB模块能够有效地应用浅层特征来抑制深层CNN特征提取过程中浅层特征丢失的现象。

3)本文提出了一种轻量级的图像超分辨率重建模型DARN,该模型在重建精度和重建效率之间取得了很好的折衷。

RELATED WORK

Deep Network for SR

SR任务自Dong等以来发展迅速。[5]提出了开创性的工作class="lazy" data-srcNN,它显着优于传统方法。随着相关研究者对SR任务的深入研究,大模型、深度卷积、特征信息全球化等优化策略对模型性能的有效性逐渐得到体现。[8]在SR任务中取得了显着的改进,这证明了深度卷积可以提高模型性能。Lim等人采用更宽的模型结构来增加模型参数以实现更好的性能。EDPN将输入图像复制成序列,并采用可变形卷积来学习图像内部自相似性。Liu等人将window transformers引入SR域,这可以加强图像全球化信息的相关性。Chen等人结合了Swin-Transformer和通道注意力机制,提出的HAT模型刷新了最先进的SR性能。这些方法在性能上取得了很大的进步,但模型参数大、计算成本高,难以部署到实际应用中。

Lightweight SR

实际任务对轻量级模型的严格要求促使研究人员专注于开发更有效的SR模型。[19]中提出的IDN可以通过两个通道分别提取特征分割的结果。[30]中依靠金字塔结构逐渐重建输入图像的高频残差特征,并且使用反卷积代替双线性插值算法也可以大大降低计算复杂度。[31]中的作者选择放弃对一对高分辨率和低分辨率图像之间的映射的直接学习,而是通过将SR任务转换为多个基滤波器的线性回归来实现模型的加速推理。[32]中提出的像素注意力网络(PAN)采用双分支架构方法,该方法以较小的参数成本提高了最终重建质量。[23]中设计的多级信息蒸馏求精结构可以实现多级特征重用。Li等人引入了可分离卷积,以较少的参数使用实现更具竞争力的性能。与其他基于深度学习的SR模型不同,LAPAR将SR任务简化为具有多个基础过滤器的线性回归任务。

从远距离收集的遥感图像质量差。因此,遥感图像的超分辨率重建是一项非常有意义的工作。LGCNet是第一个基于CNN的遥感图像SR模型,它利用局部和全局表示来学习HR图像和放大LR图像之间的图像残差。SCViT提出了一种空间通道特征保留模型,该模型考虑了高空间分辨率图像的详细几何信息。TransENet采用多尺度Transformer来聚合多维空间特征,同时专注于图像空间自相似性。由FeNeT提出的LLB模块采用信道注意机制来构建上下分支的信息通信,同时通过信道分裂来确保模型轻量化。

NETWORK ARCHITECTURE

Framework View

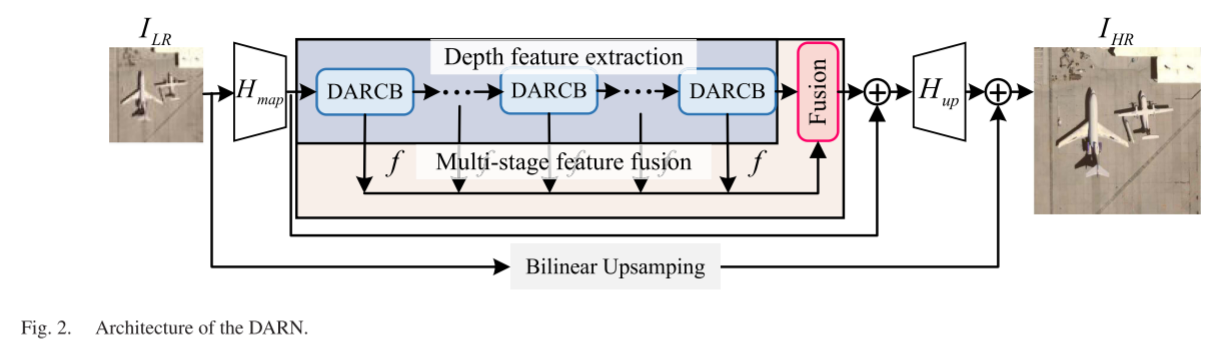

对于输入的低质量卫星遥感图像ILR,我们的方法是重建一个高质量的图像IHR,这应该是接近地面真实IGT。如图2、我们的DARN主要由四部分组成:浅层特征提取模块Hmap、由N个DARCB级联而成的深层特征提取模块、多级特征融合块Hfusion和重构模块Hup。

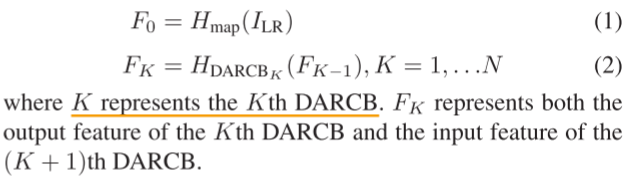

输入图像首先经过浅层特征提取块Hmap,将低维图像映射到高维空间,丰富了图像细节的表示。然后,由多个DARCB组成的深度特征提取模块逐步细化提取的特征。它可以表示为

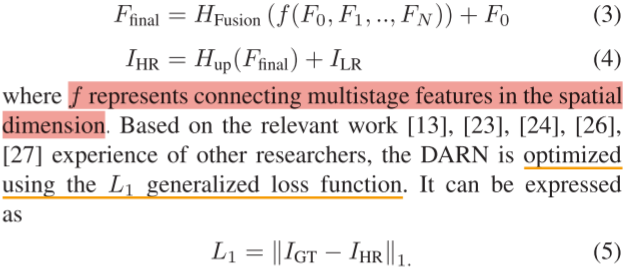

轻量级模型的优化是指在较小的模型参数约束下提高模型的性能和速度。因此,融合模型不同深度的特征是提高轻量级模型性能的有效途径。如图2、融合模块通过对多阶段特征的融合,提高了特征的重用率。我们使用融合的功能Ffinal通过重建模块Hup恢复高质量的遥感图像。此外,合理应用残差学习是提高模型性能的有效途径,上述过程可以表示为

Thinking ofLightweight Structure

网络模型体系结构的确定是模型设计阶段的第一个挑战。模型轻量化是在保证参数数量少、计算复杂度低、推理速度快的前提下,尽可能提高模型精度。常见的深度学习架构主要包括卷积、Transformer和MLP。Transformer和MLP具有较高的计算复杂度,因此它们不适合基于像素级计算的SR光任务。卷积推理速度快,计算复杂度低。合理的结构设计可以使卷盘在有限的参数下表现出优异的性能。

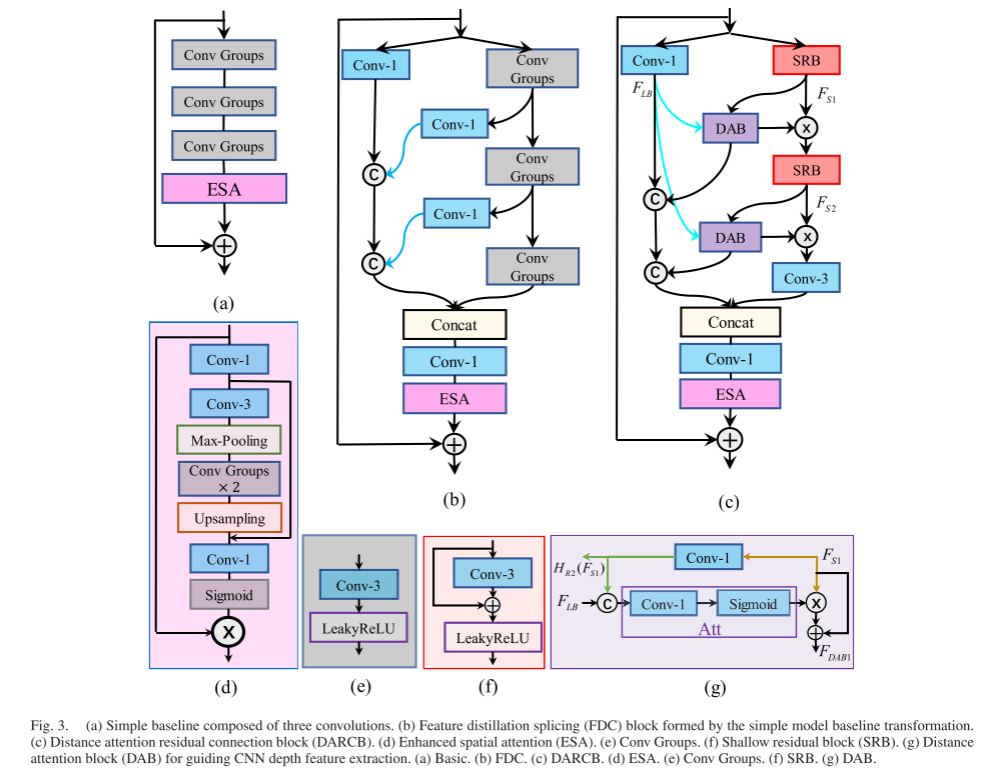

结构轻量化的思路如图3所示。为了限制模型的参数数量,我们仅使用三个3 × 3普通卷积来组成深度特征提取组件。三个Conv组和ESA模块的串联构成了我们的模型设计的基线。然而,简单的卷积级联必然会给轻量级模型带来大量的特征冗余,这不可避免地限制了构件特征提取的效率。因此,我们结合知识提取和多级特征融合,设计了一个特征提取连接(FDC)模块,FDC具有以下两个显著优势:

1)FDC在有限数量的参数内融合多级特征的方式提高了特征利用率;

2)FDC采用的蒸馏操作可以细化信道的特征信息。

在融合阶段,减小了主分支CNN模块提取的深度特征对FDC模块输出的影响。通过对各级输出权值的分配,可以有效降低主分支产生的特征冗余和随机错误对模块性能的影响。

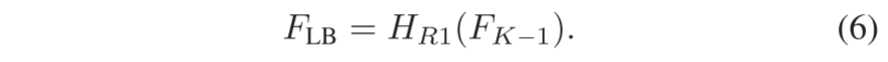

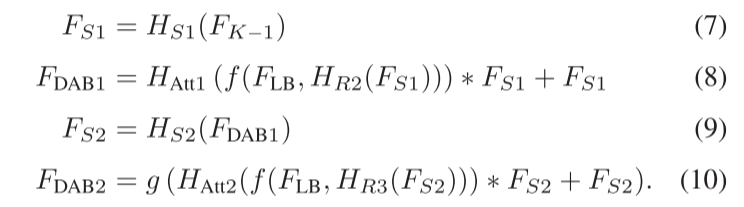

简单拼接形成的特征冗余和累积随机误差是当前CNN模型的常见问题。为了提高主分支的特征提取效率,本文设计了DAB模块,利用输入的细化特征来抑制整个主分支CNN模块细节特征的丢失。浅层特征包含了原始图像的全部信息。CNN在提取深度特征时存在特征丢失、特征冗余和错误累积等问题。因此,浅层特征监督的CNN可以有效地减少提取过程中的错误积累。此外,DAB模块中的注意机制可以补偿信息的丢失,提高有效特征的比例,减少冗余信息。AnSRB被引入作为主分支的主要构建块,以保持网络足够轻。此外,用SRB替换Conv Groups模块可以使模型能够灵活地学习残差信息,并使模型更加鲁棒。由公式(2)可知,第K个DARCB的输入特征为FK-1,输出特征为FK。DARCB首先将输入特征FK−1分为主分支和分支两条路径进行特征提取,其中分支采用特征精化卷积来保留输入特征的原始信息FLB。

其中,HR是特征细化卷积。其次,使用两个RSB模块来提取深度特征,并且使用两个DAB模块来增强深度特征提取的效率。最后,采用卷积层来细化深度特征FDAB2。具体过程可以表示为

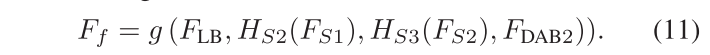

其中,HS表示RSB特征提取模块,HAtt表示DAB中的注意力机制,g表示几个卷积层。最后,DARCB融合了多级特征

为了进一步提高模型的代表性,同时保持模型的效率,我们引入了一个轻量级的ESA块。因此,可以得出结论,第k个DARN的输出特性为

一般来说,本文提出的DARCB只使用三个3 × 3卷积层来提取深度特征,这保证了模型的亮度。DAB的建议加强了特征提取,使模型在保持亮度的同时可以达到高精度。

来源地址:https://blog.csdn.net/weixin_43690932/article/details/132721298

免责声明:

① 本站未注明“稿件来源”的信息均来自网络整理。其文字、图片和音视频稿件的所属权归原作者所有。本站收集整理出于非商业性的教育和科研之目的,并不意味着本站赞同其观点或证实其内容的真实性。仅作为临时的测试数据,供内部测试之用。本站并未授权任何人以任何方式主动获取本站任何信息。

② 本站未注明“稿件来源”的临时测试数据将在测试完成后最终做删除处理。有问题或投稿请发送至: 邮箱/279061341@qq.com QQ/279061341

![[mysql]mysql8修改root密码](https://static.528045.com/imgs/44.jpg?imageMogr2/format/webp/blur/1x0/quality/35)